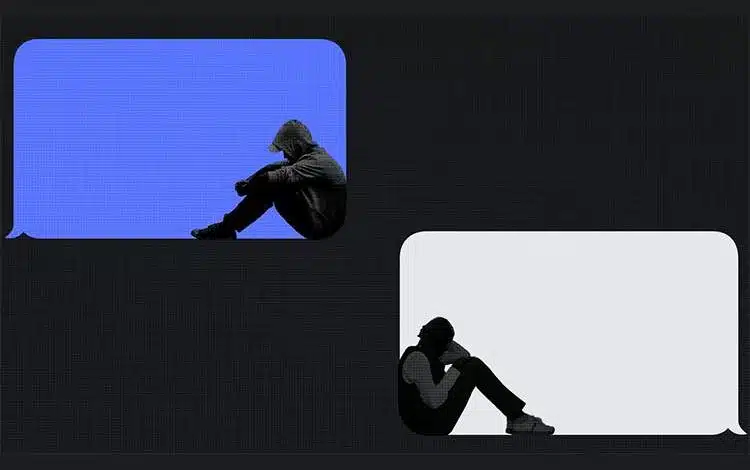

هوش مصنوعی نمیتواند علائم هشداردهنده روانی نوجوانان را به درستی تشخیص دهد

هوش مصنوعی نمیتواند علائم هشداردهنده روانی نوجوانان را به درستی تشخیص دهد

این گزارش مشکلات سیستمی گسترده در نحوه تعامل این رباتها با نوجوانان را نشان میدهد و تأکید دارد که استفاده از آنها برای درمان یا مشاوره روانی میتواند خطرناک باشد.

به گزارش دیتاسنتر من از Axios ، اهمیت این موضوع زمانی روشن میشود که بدانیم نوجوانان و حتی بزرگسالان به دلیل راحتی و دسترسی آسان، به چتباتها روی میآورند؛ هرچند کارشناسان در مورد ایمن بودن این شیوه اختلاف نظر دارند و بهویژه در خصوص استفاده پدر و مادرها از ChatGPT در تربیت کودکان عموما تاکید دارند که هوش مصنوعی جای والدین را نمیگیرد.

این مطالعه که با همکاری آزمایشگاه Brainstorm برای نوآوری سلامت روان در دانشگاه استنفورد مدیسین انجام شده است، نشان میدهد که چتباتهای شناختهشدهای مانند ChatGPT، Claude، Gemini و Meta AI قادر نیستند شرایط روانی نوجوانان را به درستی تشخیص دهند یا پاسخ مناسبی ارائه کنند.

کارشناسان معتقدند این رباتها اساسا برای ایفای نقش درمانگر ساخته نشدهاند.

بر اساس یافتهها، چتباتها علائم هشداردهنده مهم را نادیده میگیرند و نوجوانان را به دریافت کمکهای حرفهای فوری هدایت نمیکنند. پاسخهای آنها بیشتر به سلامت جسمی تمرکز دارد تا سلامت روان، و «به راحتی حواسشان پرت میشود.»

چتباتها به دلیل کارایی در انجام تکالیف و ابزارهای بهرهوری، حس اعتماد کاذب در نوجوانان و والدین ایجاد میکنند و باعث میشوند تصور شود این رباتها در درمان نیز مفید هستند.

گزارش گروه کامن سنس خاطرنشان کرده است که دهها میلیون مکالمه مربوط به سلامت روان بین نوجوانان و چتباتها در حال انجام است.

چتباتها همچنین به یکی از جدیدترین جبهههای دعاوی حقوقی و ایمنی آنلاین کودکان تبدیل شدهاند.

شرکتهای OpenAI، مایکروسافت، Character.AI و گوگل با پروندههایی روبهرو هستند که ادعا میکنند چتباتهای آنها در خودکشی یا آسیب روانی نوجوانان نقش داشتهاند. این شرکتها اقداماتی برای ایمنی نوجوانان ارائه کردهاند، اما کارشناسان معتقدند هنوز در جلب رضایت والدین و مدافعان حقوق کودک کوتاهی میکنند.

به گفته کارشناسان، حتی اگر چتباتها به طور مستقیم آسیبی وارد نکنند، میتوانند تشخیص و یا تلاش برای حل بحرانهای موجود در نوجوانان را به تاخیر بیندازند.

مجله خبری mydtc